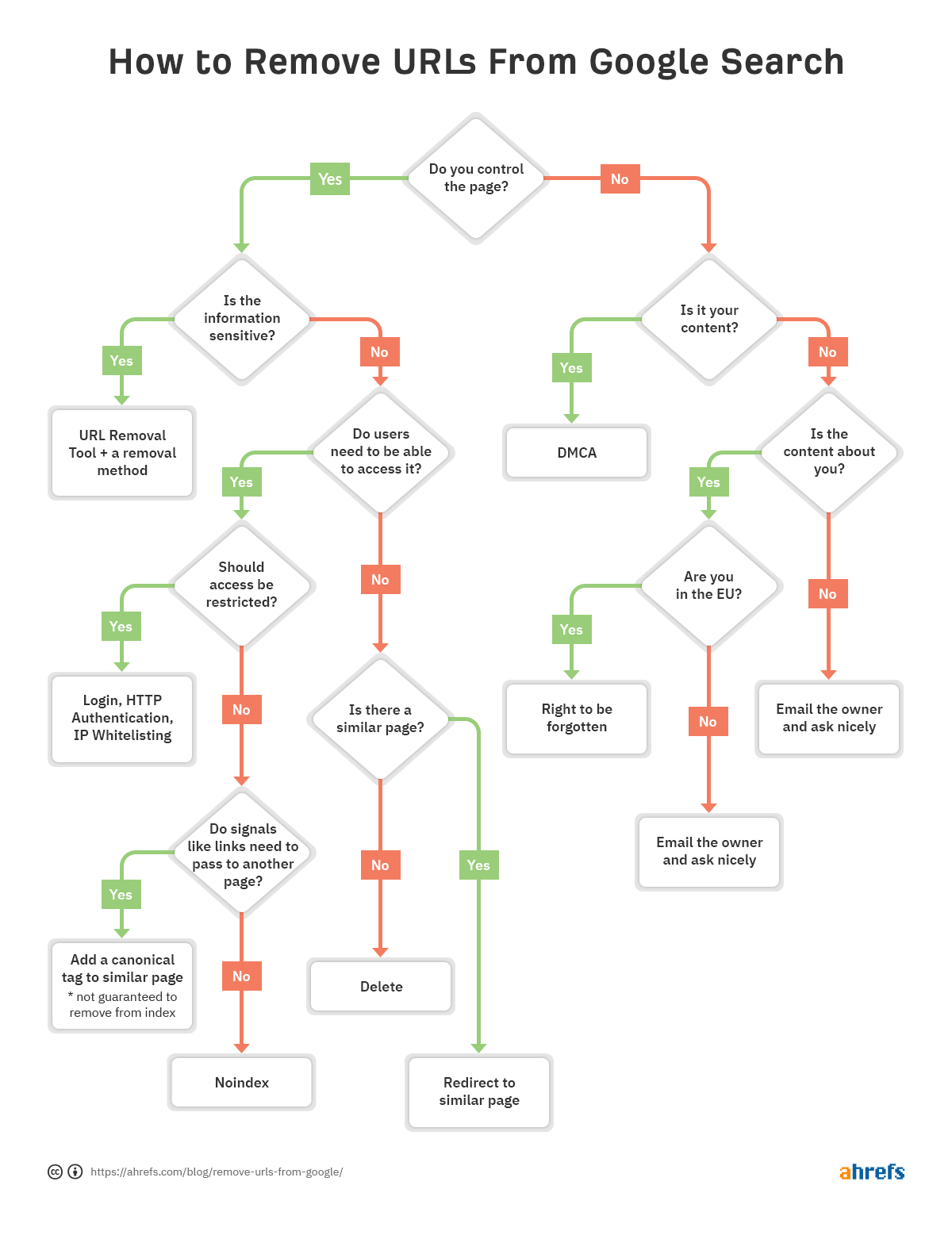

para ajudá-lo a decidir rapidamente qual o método de remoção é o melhor para você, fizemos um fluxograma para que você possa saltar para a seção relevante do artigo.

neste post, você vai aprender:

- Como verificar se uma URL é indexado

- Cinco maneiras para remover URLs do Google

- Como priorizar remoções

- Comum de remoção para evitar erros

- Como remover conteúdo que não esteja no seu site

- Como remover imagens

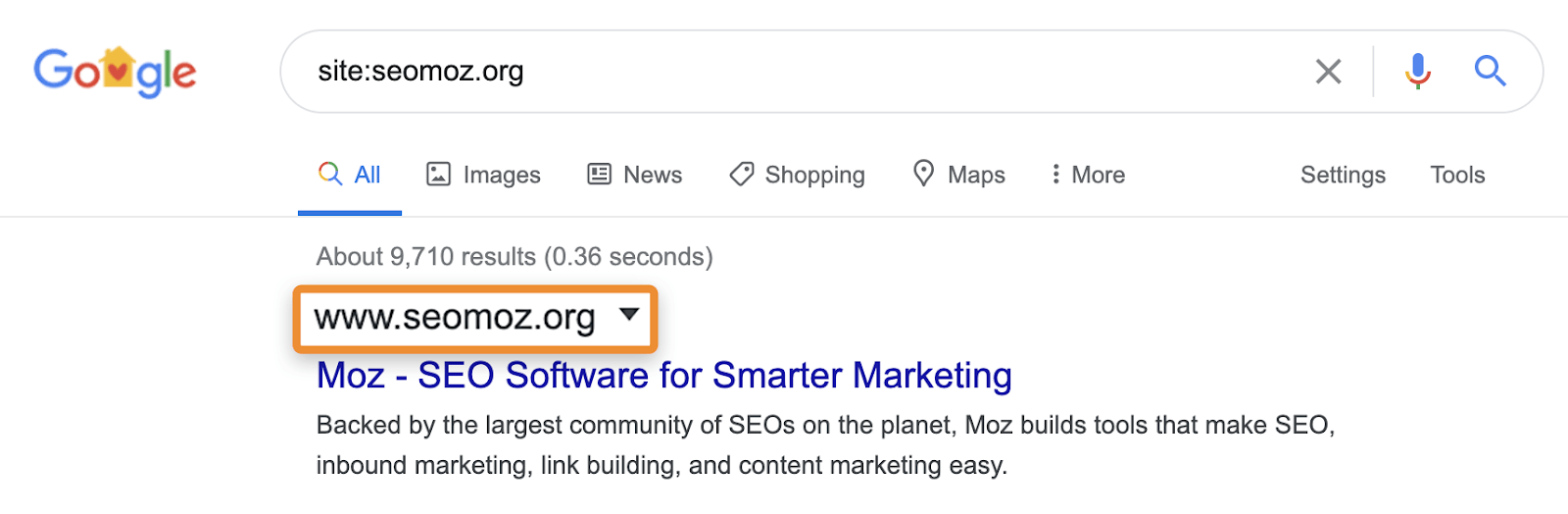

O que eu geralmente vejo SEOs fazer para verificar se o conteúdo é indexado é usar um site: pesquisar no Google (por exemplo, o site:https://ahrefs.com). Enquanto local: as pesquisas podem ser úteis para identificar as páginas ou seções de um site que podem ser problemáticas se elas aparecerem em resultados de pesquisa, você tem que ter cuidado porque não são consultas normais e não vai realmente dizer-lhe se uma página é indexada. Eles podem mostrar páginas que são conhecidas pelo Google, mas isso não significa que eles são elegíveis para mostrar em resultados de pesquisa normais sem o site: operador.

por exemplo, site: pesquisas ainda podem mostrar páginas que redirecionam ou são canonicalizadas para outra página. Quando você pede um site específico, o Google pode mostrar uma página desse domínio com o Conteúdo, Título e descrição de outro domínio. Tomemos, por exemplo, moz.com o que costumava ser seomoz.org. Qualquer utilizador regular de consultas que levam para páginas em moz.com vai mostrar moz.com no SERPs, enquanto site:seomoz.org vai mostrar seomoz.org nos resultados da pesquisa, como mostrado abaixo.

A razão esta é uma distinção importante é que ele pode levar SEOs cometer erros como ativamente bloquear ou remover URLs do índice para o antigo domínio, o que impede a consolidação de sinais, como o PageRank. Eu vi muitos casos com migrações de domínio onde as pessoas pensam que cometeram um erro durante a migração porque estas páginas ainda mostram site:old-domain.com procura e acaba prejudicando ativamente seu site enquanto tenta “corrigir” o problema.

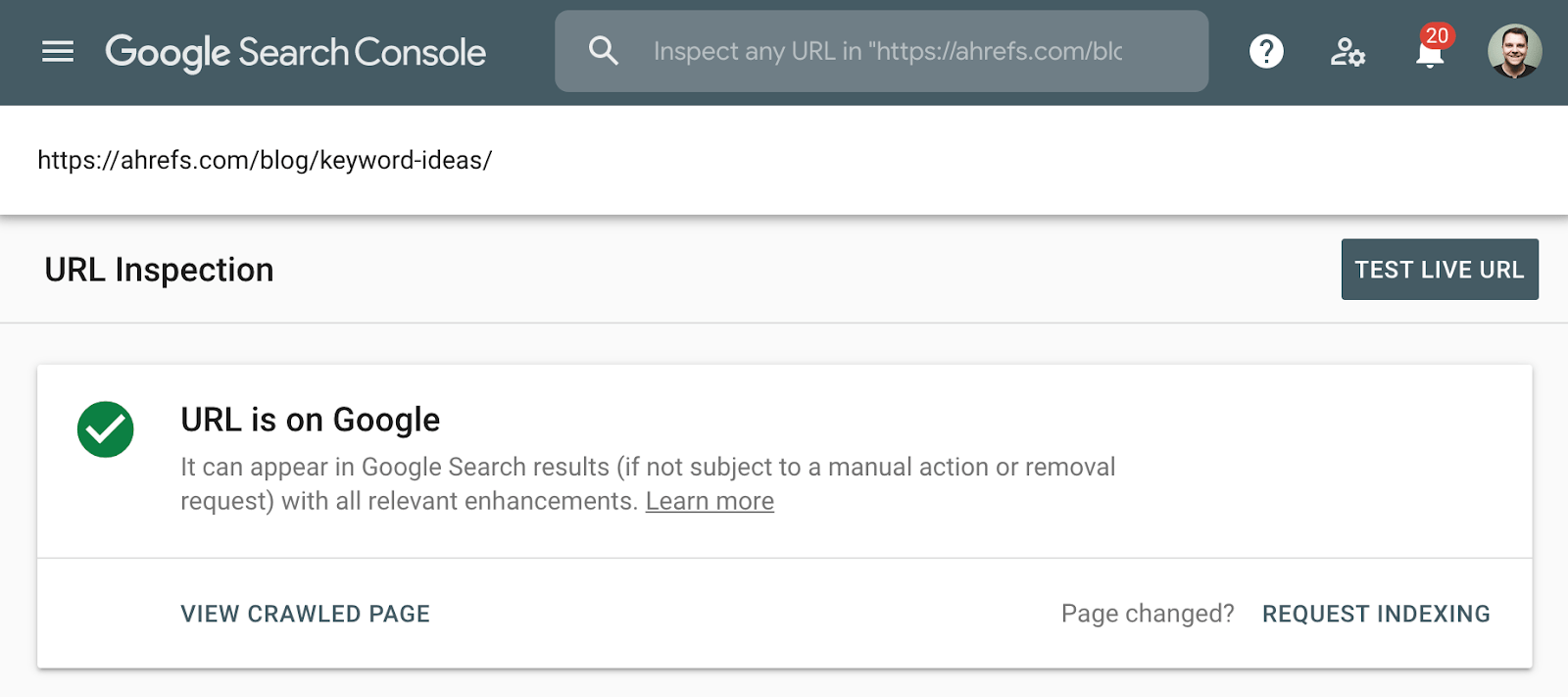

O melhor método para verificar a indexação é usar o relatório de cobertura de índice na consola de pesquisa do Google, ou a ferramenta de inspeção de URL para um URL individual. Estas ferramentas indicam se uma página é indexada e fornecem informações adicionais sobre como o Google está tratando a página. Se você não tem acesso a isso, basta procurar no Google o URL completo de sua página.

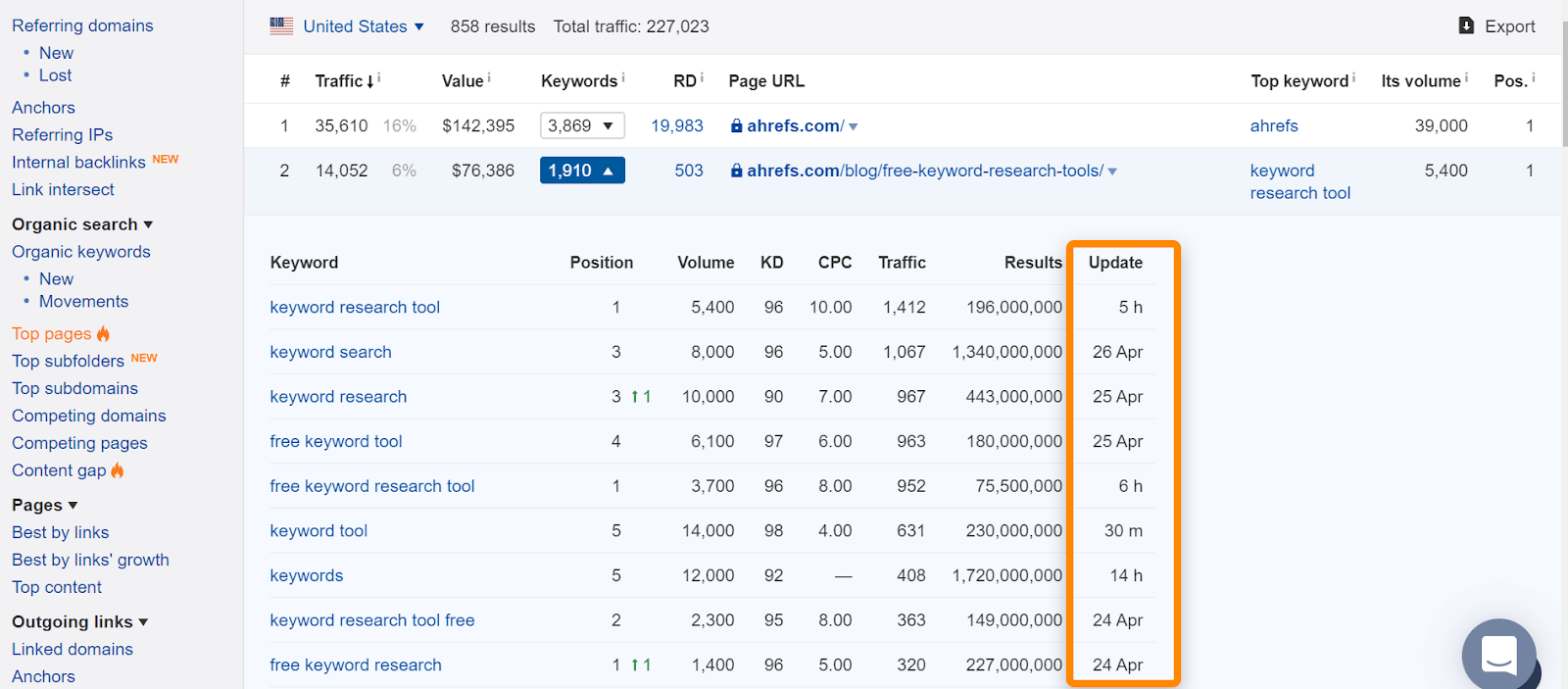

em Ahrefs, se você encontrar a página em nosso relatório de “top pages” ou ranking para palavras-chave orgânicas, geralmente significa que nós vimos ranking para consultas de pesquisa normais e é uma boa indicação de que a página foi indexada. Note que as páginas foram indexadas quando as vimos, mas isso pode ter mudado. Verifique a data da última vez que vimos a página para uma consulta.

Se houver um problema com uma determinada URL e ele precisa remover a partir do índice, siga o fluxograma no início do artigo para encontrar a correta opção de remoção, em seguida, pular para a seção apropriada abaixo.

Se você remover a página e servir tanto um código de Estado 404 (não encontrado) ou 410 (gone), então a página será removida do Índice logo após a página ser re-rastejada. Até que seja removido, a página ainda pode mostrar em resultados de pesquisa. E mesmo que a página em si não esteja mais disponível, uma versão em cache da página pode estar temporariamente disponível.

Quando você pode precisar de uma opção diferente:

- preciso de uma remoção mais imediata. Veja a secção da ferramenta de remoção de URL.preciso consolidar sinais como links. Veja a seção de canonicalização.

- eu preciso da página disponível para os usuários. Veja se as secções noindex ou restrições de acesso se encaixam na sua situação.

- opção de remoção 2: Noindex

- opção de remoção 3: restringir o acesso

- opção de remoção 4: Ferramenta de remoção de URL

- opção de remoção 5: Canonicalização

- Noindex em robôs.txt

- bloqueio de rastejar em robôs.txt

- Nofollow

- noindex and canonical to another URL

- Noindex, esperar para o Google rastrear, bloquear o rastreamento

- e se ele está satisfeito com você, mas não em um site que você possui?

- considerações Finais

opção de remoção 2: Noindex

uma marca noindex meta robots ou a resposta header X-robots irá dizer aos motores de busca para remover uma página do Índice. A marca meta robots funciona para páginas onde a resposta x‑robots funciona para páginas e tipos de arquivos adicionais como PDFs. Para que essas tags sejam vistas, um motor de busca precisa ser capaz de rastejar as páginas—então certifique-se de que eles não estão bloqueados em robôs.txt. Além disso, note que remover páginas do Índice pode impedir a consolidação de link e outros sinais.exemplo de meta-robôs noindex:

<meta name="robots" content="noindex">

Exemplo de x‑robots noindex tag no cabeçalho de resposta:

HTTP/1.1 200 OKX-Robots-Tag: noindex

Quando você pode precisar de uma opção diferente:

- eu não quiser que os usuários para acessar essas páginas. Veja a seção de restrição de acesso.preciso consolidar sinais como links. Veja a seção de canonicalização.

opção de remoção 3: restringir o acesso

Se quiser que a página esteja acessível a alguns utilizadores, mas não aos motores de busca, então o que provavelmente deseja é uma destas três opções:

- algum tipo de Sistema de autenticação;

- HTTP Autenticação (onde é necessária uma senha para acesso);

- lista de permissões de IP (que permite apenas a endereços IP específicos para acessar as páginas)

Este tipo de configuração é melhor para coisas como redes internas, membro somente o conteúdo, ou para preparação, de teste ou de desenvolvimento de sites. Ele permite que um grupo de Usuários acesse a página, mas os motores de busca não serão capazes de acessá-los e não irá indexar as páginas.

Quando você pode precisar de uma opção diferente:

- preciso de uma remoção mais imediata. Veja a secção da ferramenta de remoção de URL. Neste caso em particular, você pode querer uma remoção mais imediata se o conteúdo que você está tentando esconder foi cache, e você precisa evitar que os usuários vejam esse conteúdo.

opção de remoção 4: Ferramenta de remoção de URL

o nome desta ferramenta do Google é ligeiramente enganador, pois a forma como funciona é que irá esconder temporariamente o conteúdo. O Google ainda verá e rastejará este conteúdo, mas as páginas não aparecerão para os usuários. Este efeito temporário dura seis meses no Google, enquanto Bing tem uma ferramenta semelhante que dura três meses. Estas ferramentas devem ser usadas nos casos mais extremos para questões como questões de segurança, vazamentos de dados, informações de identificação pessoal (PII), etc. Para o Google, use a ferramenta Removals e para Bing, veja como bloquear URLs.

Você ainda precisa aplicar outro método, juntamente com o uso da ferramenta de remoção, a fim de realmente ter as páginas removidas por um período mais longo (noindex ou delete) ou impedir os usuários de acessar o conteúdo se eles ainda têm os links (apagar ou restringir o acesso). Isso só lhe dá uma maneira mais rápida de esconder as páginas enquanto a remoção tem tempo para processar. O pedido pode levar até um dia para processar.

opção de remoção 5: Canonicalização

quando você tem várias versões de uma página e quer consolidar sinais como links para uma única versão, o que você quer fazer é alguma forma de canonicalização. Isto é principalmente para evitar conteúdo duplicado, consolidando várias versões de uma página para uma única URL indexada.

tem várias opções de canonicalização:

- marca canónica. Isto indica outro URL como a versão canônica ou a versão que você deseja ser mostrada. Se as páginas forem duplicadas ou muito semelhantes, tudo bem. Quando as páginas são muito diferentes, o canônico pode ser ignorado, pois é uma sugestão e não uma diretiva.

- Redirects. Um redirecionamento leva um usuário e um bot de pesquisa de uma página para outra. 301 é o redirecionamento mais comumente usado por SEOs, e diz aos motores de busca que você quer que a URL final seja a mostrada nos resultados de busca e onde os sinais são consolidados. Um redirecionamento 302 ou temporário diz aos motores de busca que você quer que a URL original seja a única a permanecer no índice e a consolidar sinais lá.tratamento dos parâmetros do URL. Um parâmetro é adicionado ao fim do URL e normalmente inclui um ponto de interrogação, como o ahrefs.com?este=parâmetro. esta ferramenta do Google permite-lhe dizer-lhes como tratar os URLs com parâmetros específicos. Por exemplo, você pode especificar se o parâmetro muda o conteúdo da página ou se é apenas para acompanhar a utilização.

Se você tem várias páginas para remover do índice do Google, então elas devem ser priorizadas em conformidade.

prioridade máxima: estas páginas estão geralmente relacionadas com a segurança ou relacionadas com dados confidenciais. Isto inclui conteúdo que contém dados pessoais( PII), dados de clientes ou informações de propriedade.prioridade média: normalmente envolve conteúdo destinado a um grupo específico de utilizadores. Intranets da empresa ou portais de funcionários, conteúdo destinado apenas para membros, e estadiamento, teste ou ambientes de desenvolvimento.

baixa prioridade: estas páginas normalmente envolvem conteúdo duplicado de algum tipo. Alguns exemplos disso incluiriam páginas servidas de vários URLs, URLs com parâmetros, e novamente poderiam incluir ambientes de estadiamento, teste ou desenvolvimento.

I want to cover a few of the way I usually see remoções done incorrectly and what happens in each scenario to help people understand why they don’t work.

Noindex em robôs.txt

enquanto o Google usava para suportar não oficialmente o noindex nos robôs.txt, nunca foi um padrão oficial e eles agora formalmente removeram o suporte. Muitos dos sites que estavam fazendo isso estavam fazendo isso incorretamente e prejudicando a si mesmos.

bloqueio de rastejar em robôs.txt

Crawling não é a mesma coisa que indexar. Mesmo que o Google seja bloqueado de páginas de rastreamento, se houver algum link interno ou externo para uma página, eles ainda podem indexá-lo. O Google não saberá o que está na página porque não vai rastejá-lo, mas eles sabem que uma página existe e até mesmo vai escrever um título para mostrar em resultados de pesquisa com base em sinais como o texto âncora de links para a página.

Nofollow

isto geralmente fica confuso para o noindex, e algumas pessoas vão usá-lo ao nível da página esperando que a página não seja indexada. Nofollow é uma dica, e embora originalmente parou links na página e links individuais com o atributo nofollow de ser rastejado, isso não é mais o caso. O Google agora pode rastrear esses links se eles quiserem. Nofollow também foi usado em links individuais para tentar impedir o Google de rastejar através de páginas específicas e para a escultura PageRank. Mais uma vez, isto já não funciona, uma vez que não seguir é uma dica. No passado, se a página tinha outro link para ele, então o Google ainda poderia descobrir a partir deste caminho rastejante alternativo.

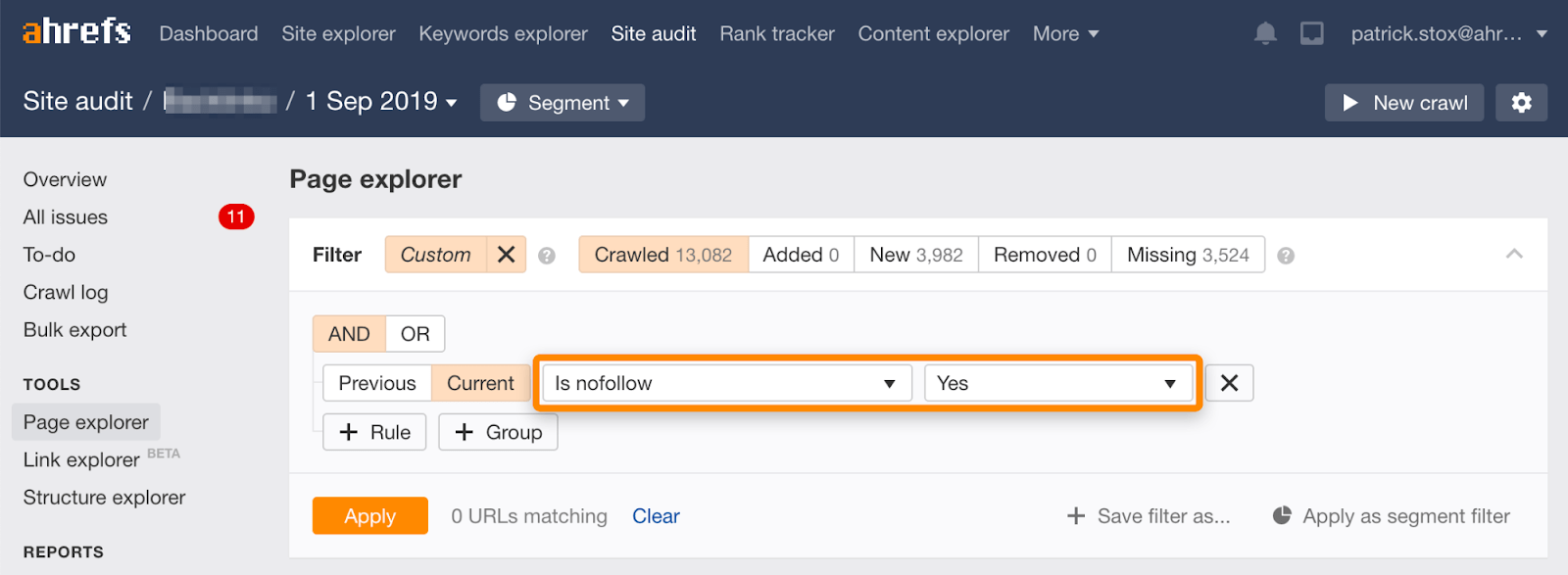

Note que você pode encontrar páginas não seguradas a granel usando este filtro no Page Explorer na auditoria do Site da Ahrefs.

Uma vez que raramente faz sentido não seguir todas as ligações numa página, o número de resultados deve ser zero ou próximo de zero. Se houver resultados correspondentes, exorto-o a verificar se a Directiva nofollow foi acrescentada acidentalmente em vez de noindex e a escolher um método mais adequado de remoção, se necessário.

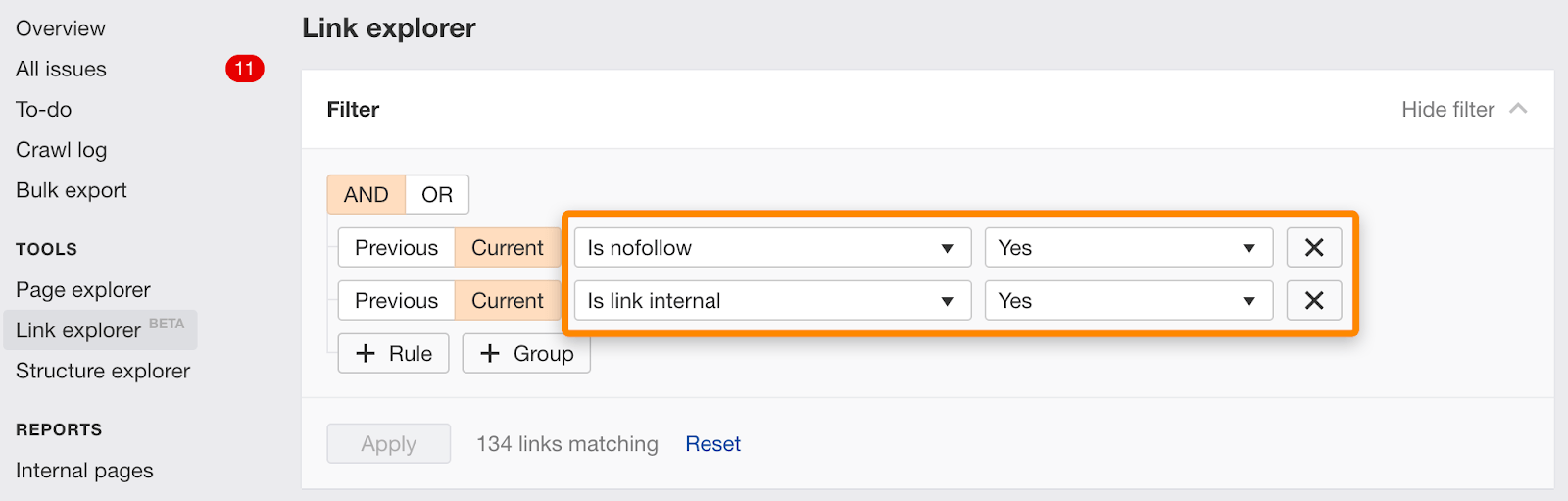

Você também pode encontrar links individuais marcados nofollow usando este filtro no Link Explorer.

noindex and canonical to another URL

estes sinais são conflitantes. Noindex diz Para remover a página do índice, e canonical diz que outra página é a versão que deve ser indexada. Isto pode realmente funcionar para a consolidação como o Google normalmente vai optar por ignorar o noindex e em vez usar o canônico como o sinal principal. No entanto, este não é um comportamento absoluto. Há um algoritmo envolvido e há o risco de que a etiqueta noindex possa ser o sinal contado. Se for esse o caso, as páginas não se consolidam correctamente.

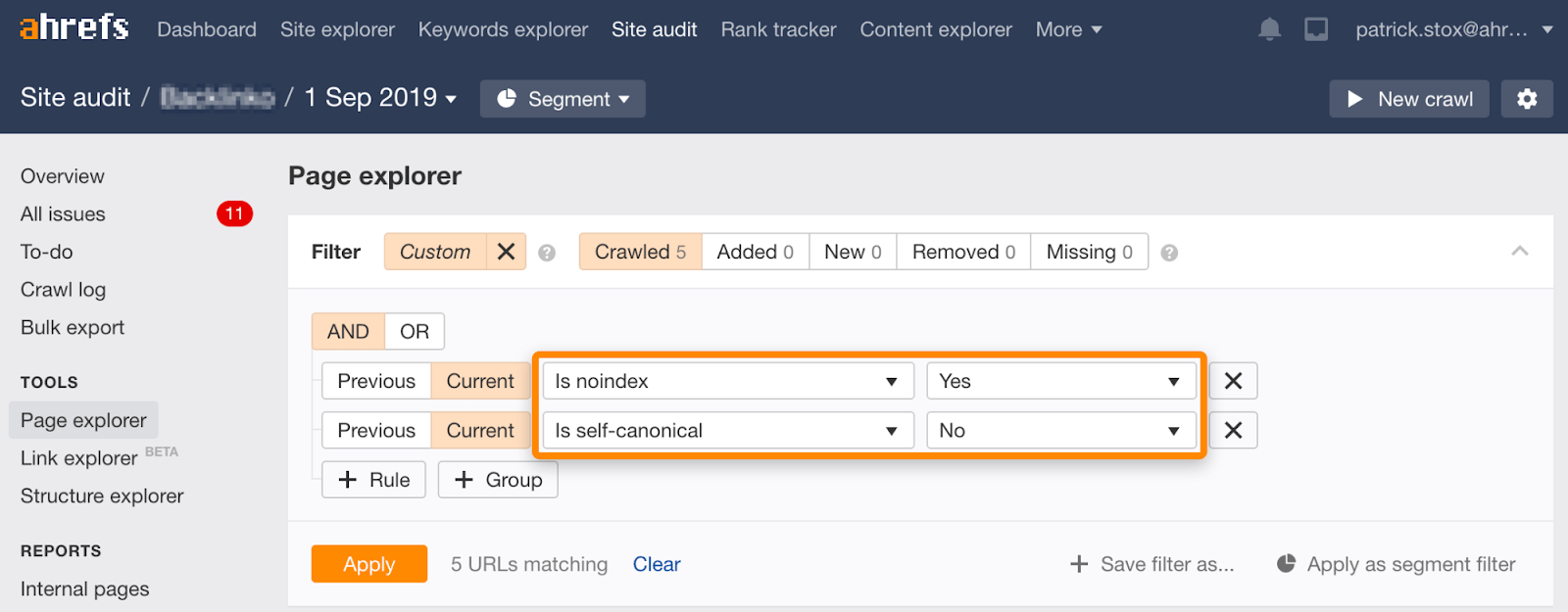

Note que você pode encontrar noindexed páginas com os não-auto-referencial paramentos usando este conjunto de filtros na Página Explorer no Site de Auditoria:

Noindex, esperar para o Google rastrear, bloquear o rastreamento

Há um par de maneiras isso normalmente acontece:

- Páginas já estão bloqueados, mas são indexados, as pessoas adicione noindex e desbloquear para que o Google pode rastrear e ver o noindex, em seguida, bloquear as páginas de rastreamento novamente.

- as pessoas adicionam tags noindex para as páginas que querem removidas e depois que o Google rastejou e processou a tag noindex, eles bloqueiam as páginas de rastreamento.

de qualquer forma, o estado final está bloqueado de rastejar. Se te lembras, há pouco falámos sobre como rastejar não é o mesmo que indexar. Mesmo que estas páginas estejam bloqueadas, elas ainda podem acabar no índice.

Se você possui o conteúdo que está sendo usado em outro site, você pode ser capaz de apresentar uma reclamação com base no Digital Millennium Copyright Act (DMCA). Você pode usar a ferramenta de remoção de Direitos Autorais do Google para fazer o que é chamado de Takedown DMCA, que requer a remoção de qualquer material protegido por direitos autorais.

e se ele está satisfeito com você, mas não em um site que você possui?

Se você está na UE, você pode remover o conteúdo que contém informações sobre você graças a uma ordem judicial para o direito a ser esquecido. Pode solicitar a remoção de informações pessoais através do formulário de remoção da privacidade da UE.

para remover imagens do Google, a maneira mais fácil é com robôs.txt. Enquanto o suporte não oficial para remover páginas foi removido dos robôs.txt como mencionamos anteriormente, simplesmente desautorizar o rastejar de imagens é a maneira certa de remover imagens.

Para uma imagem simples:

User-agent: Googlebot-ImageDisallow: /images/dogs.jpg

Para todas as imagens:

User-agent: Googlebot-ImageDisallow: /

considerações Finais

Como remover URLs é bastante situacional. Falámos sobre várias opções, mas se ainda estiver confuso, o que é certo para si, volte ao fluxograma no início.

Você também pode passar pelo troubleshooter legal fornecido pelo Google para remoção de conteúdo.tem perguntas? Avisa-me no Twitter.